Лидеры кибербезопасности изо всех сил стараются идти в ногу с быстрым исследованием, внедрением и использованием в своих организациях больших языковых моделей (LLM) и генеративного искусственного интеллекта. Такие компании, как OpenAI, Anthropic, Google и Microsoft, отмечают экспоненциальный рост использования своих предложений генеративного искусственного интеллекта (ИИ) и LLM.

Альтернативы с открытым исходным кодом также демонстрируют значительный рост: широко используются сообщества ИИ, такие как Hugging Face, предлагающие модели, наборы данных и приложения технологическому сообществу. К счастью, по мере распространения генеративного ИИ и LLM развивались и соответствующие рекомендации ведущих отраслевых организаций, таких как OWASP, OpenSSF, CISA и других.

OWASP, в частности, сыграл решающую роль в предоставлении ключевых ресурсов, таких как OWASP AI Exchange, AI Security and Privacy Guide и LLM Top 10. Недавно группа выпустила «Контрольный список по кибербезопасности и управлению ИИ (LLM AI Cybersecurity & Governance Checklist)», который содержит столь необходимые рекомендации по тому, как идти в ногу с разработками в области ИИ.

Оглавление

OWASP проводит различие между типами ИИ

Контрольный список делает различия между более широкими понятиями ИИ и машинным обучением (МО), а также генеративным ИИ и LLM. Генеративный ИИ определяется как тип машинного обучения, который фокусируется на создании новых данных, в то время как LLM — это тип модели ИИ, используемый для обработки и генерации текста, подобного тому, который создает человек. Мы видим это на примере таких ведущих инструментов, как ChatGPT, который уже насчитывает более 180 миллионов пользователей и более 1,6 миллиарда посещений сайтов только в январе 2024 года.

В рамках проекта LLM Top 10 был составлен контрольный список, который поможет специалистам в области кибербезопасности идти в ногу с быстро развивающейся сферой и защититься от угроз, связанных с быстрым распространением ИИ. Он поможет выявить ключевые угрозы и обеспечить наличие в организации фундаментальных контролей для защиты бизнеса при внедрении инструментов, услуг и продуктов генеративного ИИ и LLM.

Тема ИИ может быть невероятно обширной, поэтому контрольный список призван помочь руководителям быстро определить некоторые ключевые риски, связанные с генеративным ИИ и LLM, и снабдить их соответствующими мерами по смягчению последствий и ключевыми соображениями по уменьшению рисков. Группа также подчеркивает, что контрольный список не является исчерпывающим и будет продолжать развиваться по мере распространения генеративного ИИ и LLM, а также инструментов на их основе.

Категории угроз, стратегии и типы внедрения контрольного списка

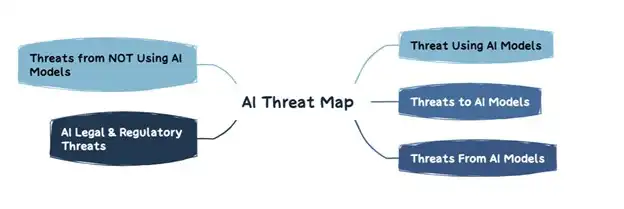

Существуют различные категории угроз LLM, которые показаны на изображении ниже:

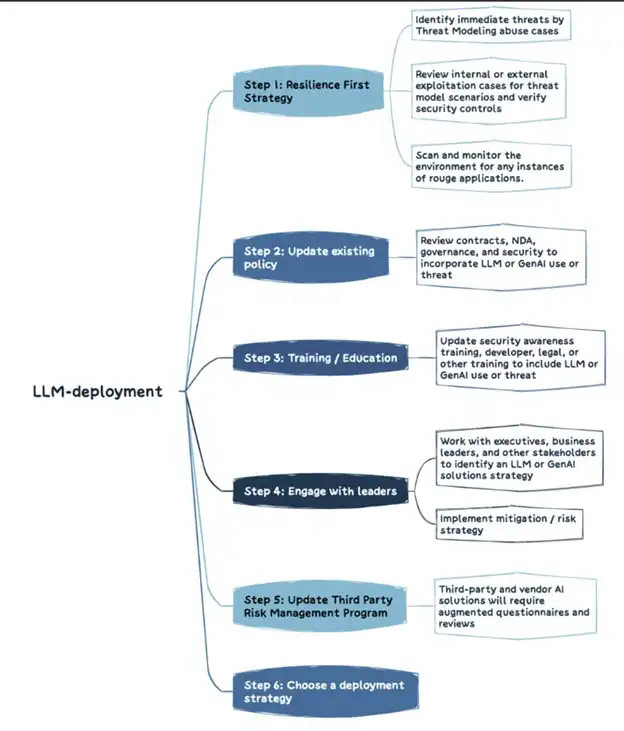

Организациям необходимо определить свою стратегию LLM и отразить в ней как они будут справляться с рисками, связанными с генеративным ИИ и LLM, и внедрять контроли для смягчения этих рисков. В публикации изложен шести-этапный практический подход для организаций по разработке своей стратегии LLM, как показано ниже:

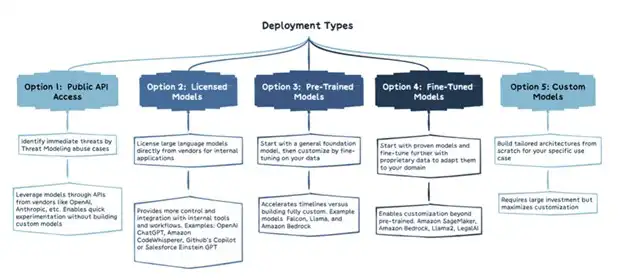

Существуют также различные типы развертывания LLM, каждый из которых имеет свои уникальные особенности, как показано ниже. Они варьируются от общедоступных моделей и лицензированных моделей до кастомизированных моделей:

Основные области контрольного списка OWASP

Ниже приводится краткое описание областей контрольного списка.

Состязательный риск

Эта область включает в себя как конкурентов, так и злоумышленников. Она ориентирована не только на среду атак, но и на бизнес-среду. Это включает в себя понимание того, как конкуренты используют ИИ для достижения бизнес-результатов, а также обновление внутренних процессов и политик, таких как планы реагирования на инциденты (IRP), для учета атак с использованием генеративного ИИ.

Моделирование угроз

Моделирование угроз включает в себя продумывание того, как злоумышленники могут использовать LLM и генеративный ИИ при эксплуатации уязвимостей, способность бизнеса обнаруживать злонамеренное использование LLM и изучение того, как организация может защитить соединения с LLM и генеративными платформами ИИ.

Инвентаризация активов ИИ

Поговорка «невозможно защитить то, о чем вы не знаете» применима и в мире генеративного искусственного интеллекта и LLM. Эта часть контрольного списка включает в себя инвентаризацию активов ИИ как для решений, разработанных внутри компании, так и для внешних инструментов и платформ.

Важно понимать не только инструменты и услуги, используемые организацией, но и кто несет ответственность за их использование. Существуют также рекомендации включать компоненты ИИ в SBOM (Software Bill of Materials) и каталогизировать источники данных ИИ и степень их чувствительности.

Помимо инвентаризации используемых инструментов, также должен быть предусмотрен процесс безопасного включения и отключения будущих инструментов и услуг.

Обучение безопасности и конфиденциальности искусственного интеллекта

Часто говорят, что «люди — самое слабое звено», однако это не обязательно так, если организация должным образом интегрирует обучение безопасности и конфиденциальности ИИ в свой процесс внедрения генеративного ИИ и LLM.

Это включает в себя помощь сотрудникам в понимании существующих генеративных AI/LLM, а также более широких технологий и принципов их функционирования, а также ключевых вопросов безопасности, таких как утечка данных. Кроме того, важно создать культуру доверия и прозрачности, чтобы сотрудники чувствовали себя комфортно и рассказывали, какие генеративные инструменты и услуги ИИ и LLM ими используются и как.

Ключевой частью предотвращения использования теневого ИИ будет доверие и прозрачность внутри организации, в противном случае сотрудники будут продолжать использовать эти платформы и просто не доводить это до сведения команд ИТ и ИБ из-за страха наказания.

Создание бизнес-кейсов для обоснования использования ИИ

Это может показаться удивительным, но, как и в случае с облачными технологиями, большинство организаций на самом деле не имеют стратегических бизнес-обоснований для использования инновационных технологий, включая генеративный ИИ и LLM. Легко попасться на ажиотаж и почувствовать, что вам нужно присоединиться к гонке или вы останетесь в отстающих. Но без убедительного экономического обоснования организация рискует получить плохие результаты, расплывчатые цели и увеличить риски.

Стратегическое управление

Без стратегического управления (Governance) достижение подотчетности и конкретных целей практически невозможно. Эта часть контрольного списка включает в себя создание диаграммы AI RACI (инструмент распределения ответственности между участниками процесса) для усилий организации по ИИ, назначение тех, кто будет нести ответственность за риски и управление, а также установление политик и процессов ИИ.

Юридический аспект

Юридические последствия использования ИИ в организации не следует недооценивать. Они быстро развиваются и могут повлиять на организацию в финансовом и репутационном плане.

Эта область включает в себя обширный список видов деятельности, таких как гарантии на продукты с использованием ИИ, лицензионное соглашение с конечным пользователем ИИ, права собственности на код, разработанный с помощью инструментов ИИ, риски интеллектуальной собственности и положения о возмещении убытков по контракту, и это лишь некоторые из них. Короче говоря, обязательно привлеките команду юристов для определения различных юридических мер, которые организация должна предпринять в рамках внедрения и использования генеративного ИИ и LLM.

Регуляторный аспект

Быстро развиваются нормативные акты, такие как Закон ЕС об искусственном интеллекте, за которым, несомненно, вскоре последуют и другие. Организация должна определить применимые к ней требования в области ИИ, получить или дать согласие на использование ИИ для конкретных целей, таких как мониторинг сотрудников, и четко понимать, как их поставщики ИИ хранят, обрабатывают и удаляют данные, а также регулируют их использование.

Использование или внедрение решений LLM

Использование решений LLM требует особого учета рисков и контроля. В контрольном списке перечислены такие элементы, как контроль доступа, безопасность конвейера обучения, рабочие процессы сопоставления данных и понимание существующих или потенциальных уязвимостей в моделях LLM и цепочках поставок. Кроме того, существует необходимость во внешних ИБ-аудитах, пентестах и даже проверке кода поставщиков на регулярной основе.

Тестирование, оценка, верификация и валидация (TEVV)

Процесс TEVV специально рекомендован NIST в его AI Framework. Это включает в себя организацию непрерывного тестирования, оценки, проверочных мероприятий на протяжении всего жизненного цикла модели ИИ, а также предоставление метрик функциональности, безопасности и надежности модели ИИ.

Карты моделей и рисков

Контрольный список призывает использовать карты моделей и рисков, чтобы пользователи могли понимать системы ИИ и доверять им, а также открыто устранять предвзятость и опасения о конфиденциальности. Эти карты могут включать такие элементы, как сведения о модели, архитектуру, методологии обучающих данных и показатели производительности. Кроме того, делается упор на учет соображений подотчетности ИИ, а также опасений по поводу справедливости и прозрачности.

RAG: оптимизация LLM

Генерация с расширенным поиском (Retrieval-augmented generation, RAG) — это способ оптимизировать возможности LLM, когда дело доходит до получения данных из конкретных источников. Это часть оптимизации предварительно обученных моделей или повторного обучения существующих моделей на новых данных для повышения производительности. Рекомендуется внедрение RAG, чтобы максимизировать ценность и эффективность LLM.

Красная команда ИИ

Наконец, в контрольном списке упоминается использование красной команды ИИ, которая имитирует атаки на системы ИИ для выявления уязвимостей и проверки существующих контролей и средств защиты. В нем подчеркивается, что «красная команда» должна быть частью комплексного подхода к обеспечению безопасности при внедрении генеративного ИИ и LLM.